解锁多模态生成新境界:探秘 OmniGen2

在人工智能技术飞速发展的当下,多模态生成模型成为了科研与应用领域的热门焦点。近日,VectorSpaceLab 推出的 OmniGen2 开源仓库,凭借其卓越的性能与创新的架构,迅速吸引了众多开发者与研究人员的目光,为多模态生成领域带来了全新的突破与可能。

一、OmniGen2 核心能力与架构优势

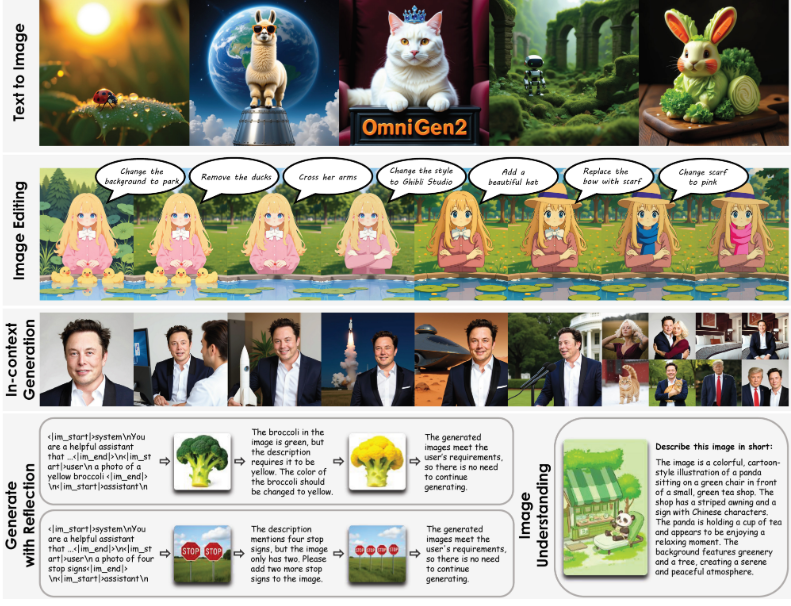

OmniGen2 是一款强大且高效的多模态生成模型,与前代 OmniGen v1 相比,它在架构设计上实现了重大革新。OmniGen2 为文本和图像模态设计了两条独立的解码路径,采用非共享参数与解耦的图像标记器,这一设计不仅提升了模型的灵活性,还显著增强了其在不同模态任务中的处理能力。在四大核心能力上,OmniGen2 均展现出了极具竞争力的表现:

视觉理解:继承了 Qwen-VL-2.5 强大的图像内容解析与分析能力,能够精准理解图像中的各类元素与信息;

文本到图像生成:根据文本提示生成高保真、极具美感的图像;

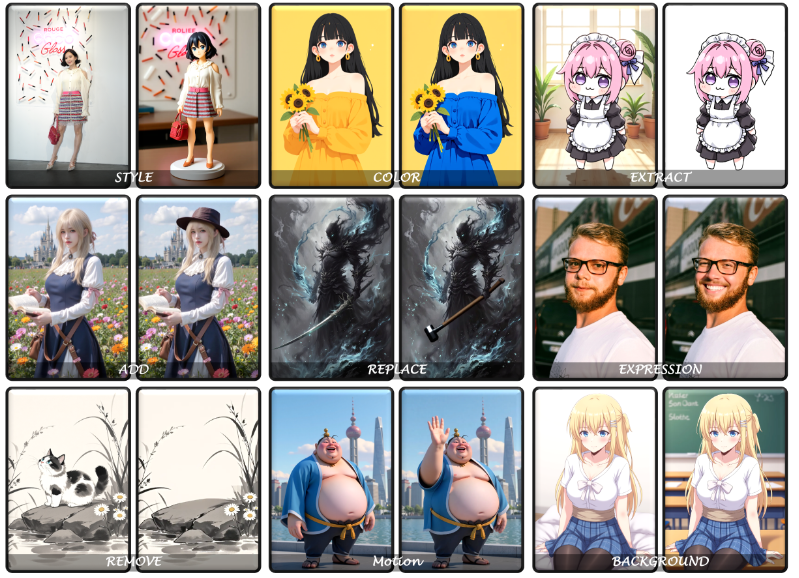

指令引导图像编辑:依据复杂指令对图像进行高精度修改,在开源模型中达到领先水平;

上下文生成:处理和融合人物、参考对象、场景等多种输入,生成新颖且连贯的视觉输出。

二、保姆级使用指南:从环境搭建到功能体验

(一)环境搭建:快速启动你的开发环境

1. 推荐配置(适用于标准开发场景)

bash

bash# 克隆仓库 git clone git@github.com:VectorSpaceLab/OmniGen2.git cd OmniGen2创建 Python 环境(可选)

conda create -n omnigen2 python=3.11

conda activate omnigen2安装 PyTorch(CUDA 12.4 版本)

pip install torch==2.6.0 torchvision --extra-index-url https://download.pytorch.org/whl/cu124

安装依赖

pip install -r requirements.txt

安装 flash-attn(优化性能,非必需但推荐)

bashpip install flash-attn==2.7.4.post1 --no-build-isolation

2. 中国大陆用户专属优化(镜像加速)

bash

bash# 使用国内镜像安装 PyTorch

pip install torch==2.6.0 torchvision --index-url https://mirror.sjtu.edu.cn/pytorch-wheels/cu124使用清华镜像安装其他依赖

bashpip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install flash-attn==2.7.4.post1 --no-build-isolation -i https://pypi.tuna.tsinghua.edu.cn/simple

注意:若使用 CUDA 12.6 或更高版本,可尝试更新 flash-attn 至最新版以获得更好兼容性。

(二)一键体验核心功能:4 大场景快速入门

1. 视觉理解:解析图像内容

bash

bashbash example_understanding.sh

输入:指定图像路径,模型将输出对图像中物体、场景、动作等元素的自然语言描述。

2. 文本到图像生成(T2I):文字秒变视觉画面

bash

bashbash example_t2i.sh

参数示例:

python

python--prompt "a cyberpunk city at night, neon lights, flying cars" # 主提示词

--negative_prompt "blurry, low quality, watermark" # 负面提示词(避免生成内容)

--num_inference_steps 50 # 推理步数(默认 50,可调整画质)

3. 指令引导图像编辑:精准修改现有图像

bash

bashbash example_edit.sh

操作流程:

准备原始图像(输入路径)和编辑指令(如 “将天空从蓝色改为紫色,添加彩虹”);

运行脚本,通过

控制编辑对原图的依赖程度(推荐 1.2-2.0)。--image_guidance_scale

4. 上下文生成:多图融合创作

bash

bashbash example_in_context_generation.sh

典型场景:将人物从一张图迁移到另一张图的场景中,并保持风格一致。

prompt 模板:

plaintext

plaintext"Edit the first image: add the cat from the second image. The cat is sitting on a windowsill, sunny day, realistic style."

(三)Gradio 可视化演示:零代码快速上手

1. 在线 demo(无需本地部署)

访问 Hugging Face Spaces 或备用链接(Demo1/Demo2 等),直接在网页中输入文本或上传图像进行操作。

2. 本地运行可视化界面

bash

bash# 仅生成图像

pip install gradio

python app.py # 启动基础版界面

python app.py --share # 生成公共链接,可分享给他人访问图文交互(支持文本+图像输入)

bashpip install gradio

python app_chat.py

三、进阶技巧:参数调优与性能优化

(一)关键参数调整指南

参数名称功能描述推荐值范围

text_guidance_scaleimage_guidance_scale上下文生成:2.5-3.0

max_pixelsenable_model_cpu_offloadcfg_range_end(二)显存不足解决方案

方案 1:启用

,将非活跃模型权重卸载到 CPU,适用于 8GB+ 显存设备。enable_model_cpu_offload方案 2:启用

,将 VRAM 占用压至 3GB 以下,但速度会显著变慢,适合低配置设备。enable_sequential_cpu_offload

(三)提升生成质量的实用技巧

输入高质量图像:确保原图分辨率 ≥512×512 像素,模糊或过小的图像会导致输出失真。

精细化指令:明确描述 “改什么” 和 “怎么改”,例如:

“将左侧人物的红色上衣改为蓝色,添加金色纽扣,背景中加入樱花树,风格保持写实。”优先使用英文提示:模型对英文指令的理解更精准,可搭配翻译工具优化中文输入。

批量生成筛选结果:通过

一次生成多张图,提高选中理想结果的概率。--num_images_per_prompt 4

四、社区生态与未来展望

目前,OmniGen2 开源仓库已收获 2.5k 星标、185 次复刻和 28 位关注者,开源社区积极贡献了 ComfyUI 集成方案、量化压缩等非官方成果。尽管模型仍存在指令遵循度不足、无法自主调整输出尺寸等局限性,但官方持续更新训练代码、优化资源适配,并计划推出 OmniContext 基准测试与 diffusers 集成。

OmniGen2 的诞生标志着多模态生成技术向通用化、实用化迈出了重要一步。无论是 AI 艺术创作、视觉内容编辑,还是科研领域的跨模态数据处理,它都展现出了巨大潜力。欢迎开发者访问 OmniGen2 仓库,参与开源共建,共同探索多模态生成的无限可能!

评论 (0)

帖子数据

楼主信息

相关帖子

社区规则

• 保持友善,尊重他人

• 发表有价值的内容

• 禁止发布垃圾信息

• 遵守法律法规