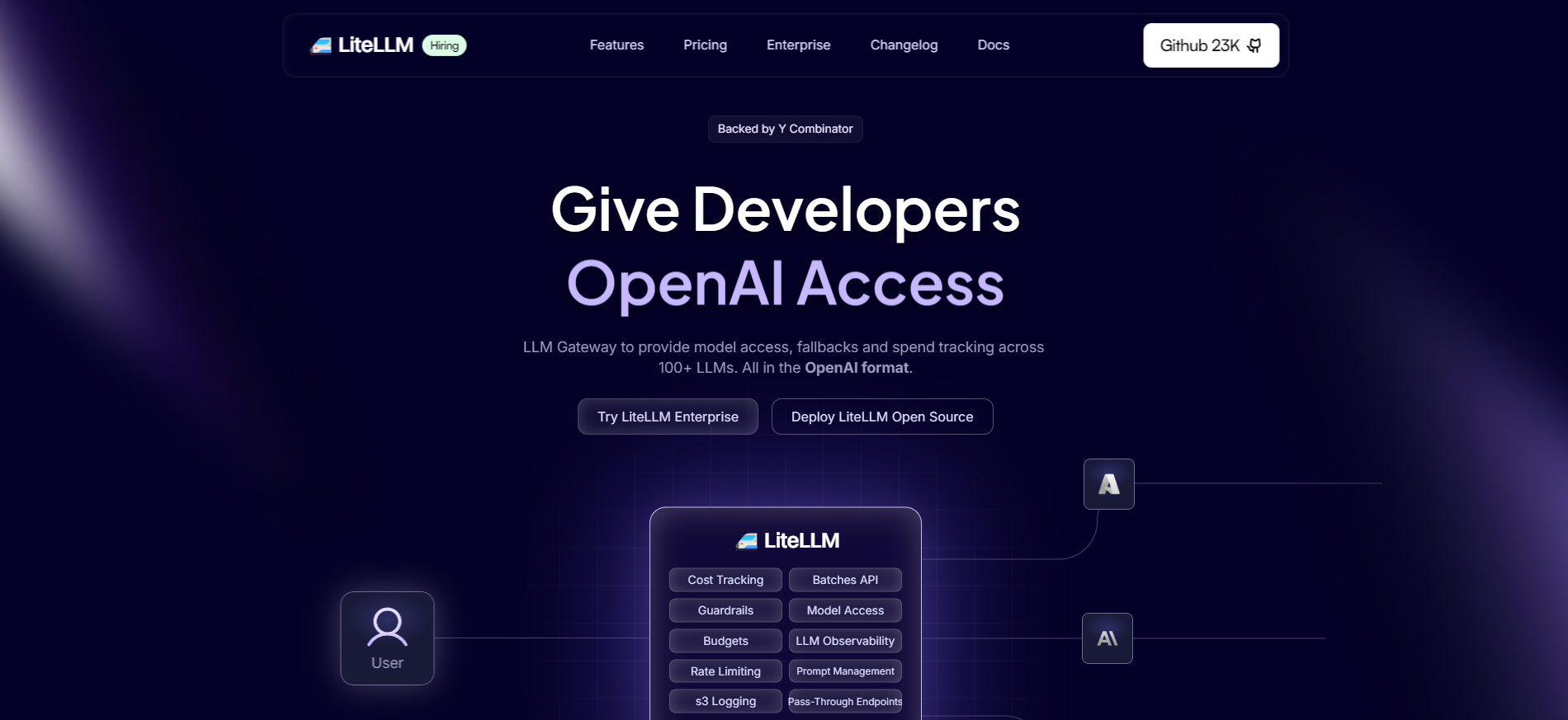

LiteLLM

开源 LLM 网关,统一管理 100 多种大型语言模型的访问、负载均衡和费用跟踪。

工具介绍

LiteLLM 是一个开源的大型语言模型(LLM)网关,通过统一的 OpenAI 格式接口,简化对 100 多种 LLM(如 OpenAI、Azure、Anthropic、Bedrock、HuggingFace)的访问、管理和优化。开发者可以通过 Python SDK 或代理服务器(LLM Gateway)调用不同模型,无需为每个提供商学习独立的 API。平台支持核心功能包括负载均衡、自动重试、故障切换、费用跟踪和虚拟密钥管理。用户可设置按项目、密钥或模型的预算和速率限制,确保成本控制和资源分配的透明性。此外,LiteLLM 支持日志记录到 S3、GCS、Langfuse 等平台,方便实时监控和分析。

LiteLLM 的特点是其灵活性和企业级功能。平台提供统一的 API 格式,降低多模型集成的复杂性,开发者只需编写一次代码即可跨平台调用。支持流式响应(stream=True)以处理大模型输出,适合内存密集型任务。其开源版本完全免费,允许本地部署以保护数据隐私;企业版则提供 SSO、JWT 认证和 Prometheus 监控等高级功能,适合大规模团队。社区活跃,GitHub 上拥有超过 12,000 星,150+ 贡献者提供持续更新和支持,文档详尽,涵盖从快速入门到自定义定价的指南。LiteLLM 还支持嵌入模型和图像生成端点,扩展了其在多模态 AI 任务中的应用。

使用场景广泛。初创公司可通过 LiteLLM 快速集成多种 LLM,测试不同模型的效果;大型企业可利用其预算管理和负载均衡功能,优化内部 AI 工作流;教育机构可用于教学,探索模型特性和提示设计。例如,开发者可通过 LiteLLM 结合 LangChain 构建聊天机器人,或通过 API 自动化代码审查。平台还支持与 OpenTelemetry 和 Datadog 集成,适合需要高可观测性的生产环境。无论是快速原型开发还是企业级 AI 部署,LiteLLM 都提供了高效、统一的解决方案。

主要功能

相关标签

暂无评价

成为第一个评价这个工具的用户吧!